Veröffentlicht am: 15. Oktober 2025

13 Minuten Lesezeit

Was ist ein Large Language Model (LLM)?

Erfahre, wie Large Language Models funktionieren, welche Anwendungen es gibt und welchen Einfluss sie auf die DevSecOps-Welt haben.

Large Language Models (LLMs) verändern DevOps- und DevSecOps-Ansätze grundlegend, indem sie komplexe Aufgaben wie Code-Erstellung, Log-Analyse und Vulnerability Detection vereinfachen. In diesem Artikel erfährst du, wie LLMs funktionieren, welche praktischen Anwendungen es gibt und welche Herausforderungen gemeistert werden müssen, um ihr Potenzial voll auszuschöpfen.

Für deutsche Entwicklungsteams sind LLMs besonders relevant, da sie repetitive Aufgaben automatisieren und die Einhaltung von Compliance-Anforderungen unterstützen können – beispielsweise in regulierten Branchen wie Finanzdienstleistungen oder der Automobilindustrie.

Was ist ein LLM?

LLMs sind KI-Systeme (Künstliche Intelligenz), die autonom Text verarbeiten und generieren können. Sie werden trainiert, indem sie große Datenmengen aus verschiedenen Quellen analysieren, wodurch sie linguistische Strukturen, kontextuelle Beziehungen und sprachliche Nuancen beherrschen.

LLMs stellen einen bedeutenden Fortschritt im KI-Bereich dar. Ihre Fähigkeit, Text zu verarbeiten, zu generieren und zu interpretieren, basiert auf ausgereiften Machine-Learning- und Natural-Language-Processing-Techniken (NLP). Diese Systeme verarbeiten nicht nur einzelne Wörter, sondern analysieren komplexe Sequenzen, um die Gesamtbedeutung, subtile Kontexte und linguistische Nuancen zu erfassen.

Wie funktionieren LLMs?

Um besser zu verstehen, wie sie funktionieren, betrachten wir einige Schlüsseleigenschaften von Large Language Models.

Supervised und Unsupervised Learning

LLMs werden mit zwei komplementären Ansätzen trainiert: Supervised Learning und Unsupervised Learning. Diese beiden Machine-Learning-Ansätze maximieren ihre Fähigkeit, Text zu analysieren und zu generieren.

-

Supervised Learning basiert auf gelabelten Daten, bei denen jeder Input mit einem erwarteten Output verknüpft ist. Das Modell lernt, diese Inputs mit den korrekten Outputs zu assoziieren, indem es seine internen Parameter anpasst, um Vorhersagefehler zu reduzieren. Durch diesen Ansatz erwirbt das Modell präzises Wissen über spezifische Aufgaben wie Textklassifikation oder Named Entity Recognition.

-

Unsupervised Learning (oder maschinelles Lernen) benötigt hingegen keine gelabelten Daten. Das Modell erkundet große Textmengen, um versteckte Strukturen zu entdecken und semantische Beziehungen zu identifizieren. Das Modell kann daher wiederkehrende Muster, implizite grammatikalische Regeln im Text und die Kontextualisierung von Sätzen und Konzepten lernen. Diese Methode ermöglicht es, LLMs auf großen Datenkorpora zu trainieren, was ihren Fortschritt ohne direkte menschliche Intervention erheblich beschleunigt.

Durch die Kombination dieser beiden Ansätze gewinnen Large Language Models die Vorteile sowohl präzisen, menschlich geführten Lernens als auch unbegrenzter autonomer Exploration. Diese Komplementarität ermöglicht es ihnen, sich schnell zu entwickeln und gleichzeitig ihre Fähigkeit zu verbessern, Text kohärent und kontextuell zu verstehen und zu generieren.

Training auf großen Datenmengen

LLMs werden auf Milliarden von Sätzen aus verschiedenen Quellen trainiert, wie Nachrichtenartikeln, Online-Foren, technischer Dokumentation, wissenschaftlichen Studien und mehr. Diese Quellenvielfalt ermöglicht es ihnen, ein breites und nuanciertes Verständnis natürlicher Sprache zu erwerben, das von alltäglichen Ausdrücken bis zu Fachterminologie reicht.

Der Reichtum der verwendeten Daten ist ein Schlüsselfaktor für die Leistung von LLMs. Jede Quelle bringt unterschiedliche Schreibstile, kulturelle Kontexte und technische Niveaus mit sich. Zum Beispiel:

- Nachrichtenartikel, um informative und faktische Sprache zu beherrschen

- Online-Foren, um informelle Unterhaltungen und Fachsprache spezialisierter Communities zu verstehen

- Technische Dokumentation und wissenschaftliche Studien, um komplexe Konzepte und spezifische Terminologie zu assimilieren, besonders in Bereichen wie DevOps und DevSecOps Diese Inhaltsvielfalt ermöglicht es LLMs, komplexe linguistische Strukturen zu erkennen, Sätze in verschiedenen Kontexten zu interpretieren und sich an hochgradig technische Domänen anzupassen. In DevSecOps bedeutet dies, Commands, Konfigurationen, Sicherheitsprotokolle und sogar Konzepte im Zusammenhang mit der Entwicklung und Wartung von Computersystemen zu verstehen. Mit diesem groß angelegten Training können LLMs komplexe Fragen präzise beantworten, technische Dokumentation schreiben oder Schwachstellen in Computersystemen identifizieren.

Neuronale Netzwerkarchitektur und Deep Learning

LLMs basieren auf fortgeschrittenen neuronalen Netzwerkarchitekturen. Diese Netzwerke sind speziell darauf ausgelegt, große Textsequenzen zu verarbeiten und dabei ein genaues Verständnis des Kontexts beizubehalten. Dieses auf Deep Learning basierende Training ist ein wichtiger Vorteil im NLP-Bereich. Die bekannteste dieser Strukturen ist die Architektur von Sequence-to-Sequence-Modellen (Transformers). Diese Architektur hat NLP mit ihrer Fähigkeit, alle Teile eines Textes gleichzeitig zu analysieren, grundlegend verändert – im Gegensatz zu sequenziellen Ansätzen, die Wörter einzeln verarbeiten.

Sequence-to-Sequence-Modelle eignen sich hervorragend für die Verarbeitung langer Texte. Beispielsweise können sie in einer Konversation oder einem detaillierten technischen Dokument entfernte Informationen im Text verknüpfen, um präzise und gut begründete Antworten zu produzieren. Dieses Kontextmanagement ist in einem DevSecOps-Ansatz essenziell, wo Anweisungen komplex sein und sich über mehrere Codezeilen oder Konfigurationsschritte erstrecken können.

Prädiktive Textgenerierung

Wenn der Benutzer einen Text, eine Abfrage oder eine Frage einreicht, nutzt ein LLM seine prädiktive Fähigkeit, um die wahrscheinlichste Sequenz basierend auf dem gegebenen Kontext zu generieren. Das Modell analysiert jedes Wort, untersucht grammatikalische und semantische Beziehungen und wählt dann die passendsten Begriffe aus, um einen kohärenten und informativen Text zu produzieren. Dieser Ansatz ermöglicht es, präzise, detaillierte und an den erwarteten Ton angepasste Antworten zu generieren.

In DevSecOps-Umgebungen wird diese Fähigkeit besonders nützlich für:

- Coding-Unterstützung: Generierung von Code-Blöcken oder Scripts, die an spezifische Konfigurationen angepasst sind

- Technische Problemlösung: Lösungsvorschläge basierend auf Beschreibungen von Bugs oder Fehlern

- Erstellung technischer Dokumentation: Automatische Erstellung von Anleitungen, Handbüchern oder Anweisungen Die prädiktive Textgenerierung ermöglicht es somit, viele repetitive Aufgaben zu automatisieren und die Arbeit technischer Teams zu beschleunigen.

Anwendungen von Large Language Models im DevSecOps-Ansatz

Mit dem Aufstieg der Automatisierung sind LLMs zu unverzichtbaren Unterstützern für technische Teams geworden. Ihre Fähigkeit, Text kontextuell zu verstehen und zu generieren, ermöglicht es ihnen, effektiv in komplexen Umgebungen wie DevSecOps zu arbeiten.

Mit ihrer Analysekraft und Anpassungsfähigkeit an spezifische Bedürfnisse bieten diese Modelle maßgeschneiderte Lösungen, um Prozesse zu straffen und die Arbeitslast technischer Teams zu reduzieren.

Entwicklungsteams können LLMs nutzen, um funktionale Spezifikationen automatisch in Quellcode umzuwandeln.

Mit dieser Fähigkeit können sie folgende Aktionen durchführen:

- Komplexe Automatisierungsskripte generieren

- CI/CD-Pipelines erstellen, die auf spezifische Geschäftsprozesse zugeschnitten sind

- Individuelle Sicherheitspatches produzieren

- Code-Erklärungen generieren und Dokumentation erstellen

- Code refaktorisieren, indem Struktur und Lesbarkeit verbessert werden, ohne die Funktionalität zu ändern

- Tests generieren Durch den Einsatz von LLMs können Teams die Entwicklung ihrer Software beschleunigen und gleichzeitig das Risiko menschlicher Fehler reduzieren.

Verbesserte Dokumentation und Wissensaustausch

Diese leistungsstarken Tools ermöglichen es, maßgeschneiderte Benutzerhandbücher, API-Beschreibungen und Tutorials zu erstellen, die perfekt auf das Expertise-Level jedes Benutzers abgestimmt sind. Durch die Nutzung vorhandener Wissensbasen erstellen LLMs kontextuelle Antworten auf häufig gestellte Fragen. Dies verbessert den Wissensaustausch innerhalb von Teams, beschleunigt das Onboarding neuer Mitglieder und hilft, Best Practices zu zentralisieren.

Incident Management und Troubleshooting

Während eines Incidents spielen LLMs eine entscheidende Rolle bei der Echtzeit-Analyse von Logs und Trace-Dateien. Dank ihrer Fähigkeit, Informationen aus mehreren Quellen zu verknüpfen, identifizieren sie Anomalien und schlagen Lösungen basierend auf ähnlichen vergangenen Incidents vor. Dieser Ansatz reduziert die Diagnosezeit erheblich. Zusätzlich können LLMs die Erstellung detaillierter Incident-Reports automatisieren und spezifische Korrekturmaßnahmen empfehlen.

Erstellung und Verbesserung von CI/CD-Pipelines

LLMs verändern die Konfiguration von CI/CD-Pipelines grundlegend. Sie können nicht nur bei der Erstellung von Pipelines helfen, sondern auch diesen Prozess automatisieren und optimale Konfigurationen basierend auf Industriestandards vorschlagen. Durch die Anpassung von Workflows an spezifische Bedürfnisse gewährleisten sie perfekte Konsistenz zwischen verschiedenen Entwicklungsumgebungen. Automatisierte Tests werden durch relevante Vorschläge verbessert, wodurch das Fehlerrisiko begrenzt wird. LLMs überwachen auch kontinuierlich die Effizienz von Pipelines und passen Prozesse an, um einen reibungslosen und unterbrechungsfreien Rollout sicherzustellen.

Sicherheit und Compliance

In einer DevSecOps-Umgebung werden Large Language Models zu wertvollen Unterstützern für Sicherheit und Compliance. Sie analysieren den Quellcode auf potenzielle Schwachstellen und generieren detaillierte Patch-Empfehlungen. LLMs können auch die Anwendung von Sicherheitsstandards in Echtzeit überwachen, umfassende Compliance-Reports produzieren und die Anwendung von Sicherheitspatches automatisieren, sobald eine Schwachstelle identifiziert wird. Diese Automatisierung erhöht die Gesamtsicherheit und gewährleistet konsistente Compliance mit rechtlichen und branchenspezifischen Anforderungen.

Was sind die Vorteile von Large Language Models?

LLMs gestalten DevOps- und DevSecOps-Ansätze neu und bringen substanzielle Verbesserungen in Produktivität, Sicherheit und Softwarequalität. Durch die Integration in bestehende Workflows verändern LLMs traditionelle Ansätze, indem sie komplexe Aufgaben automatisieren und innovative Lösungen bieten.

Verbesserte Produktivität und Effizienz

LLMs spielen eine zentrale Rolle bei der Verbesserung der Produktivität und Effizienz technischer Teams. Durch die Automatisierung einer breiten Palette repetitiver Aufgaben befreien sie Entwicklungsteams von Routineoperationen und ermöglichen es ihnen, sich auf strategische Aktivitäten mit höherem Mehrwert zu konzentrieren.

Darüber hinaus agieren LLMs als intelligente technische Assistenten, die sofort relevante Code-Snippets liefern können, die auf den spezifischen Kontext jedes Projekts zugeschnitten sind. Auf diese Weise reduzieren sie die Recherchezeit erheblich, indem sie gebrauchsfertige Lösungen zur Unterstützung von Teams bei ihrer Arbeit anbieten. Diese gezielte Unterstützung beschleunigt die Problemlösung und reduziert Unterbrechungen in Workflows.

Als Ergebnis steigt die Produktivität und Projekte kommen schneller voran. Technische Teams können mehr Aufgaben übernehmen, ohne die Qualität der Deliverables zu beeinträchtigen.

Verbesserte Code-Qualität und Sicherheit

Der Einsatz von Large Language Models in der Softwareentwicklung ist ein wichtiger Hebel zur Verbesserung sowohl der Code-Qualität als auch der Anwendungssicherheit. Mit ihren fortgeschrittenen Analysefähigkeiten können LLMs Quellcode Zeile für Zeile scannen und sofort Syntaxfehler, logische Inkonsistenzen und potenzielle Schwachstellen erkennen. Ihre Fähigkeit, fehlerhaften Code zu erkennen, ermöglicht es ihnen, angemessene Korrekturen zu empfehlen, die den Best Practices der Branche entsprechen.

LLMs spielen auch eine wichtige präventive Rolle. Sie sind hervorragend darin, komplexe Sicherheitslücken zu identifizieren, die für Menschen oft schwer zu erkennen sind. Durch die Analyse von Dependencies können sie veraltete oder anfällige Bibliotheken kennzeichnen und sicherere, aktualisierte Versionen empfehlen. Dieser Ansatz trägt dazu bei, eine sichere Umgebung aufrechtzuerhalten, die den aktuellen Sicherheitsstandards entspricht.

Über die Behebung bestehender Fehler hinaus bieten LLMs Verbesserungen, indem sie optimierte Coding-Praktiken und Projektstrukturen vorschlagen. Sie können Code generieren, der den fortschrittlichsten Sicherheitsstandards von den frühesten Entwicklungsstadien an entspricht.

Beschleunigung von Entwicklungszyklen

Large Language Models spielen eine Schlüsselrolle bei der Beschleunigung von Softwareentwicklungszyklen, indem sie zentrale Aufgaben automatisieren, die andernfalls wertvolle menschliche Ressourcen binden würden. Komplexe und repetitive Aufgaben wie das Schreiben von Funktionen, die Erstellung von Unit-Tests oder die Implementierung von Standardkomponenten werden in wenigen Momenten automatisiert.

LLMs beschleunigen auch die Validierungsphase mit ihrer Fähigkeit, vollständige und angemessene Testfälle vorzuschlagen. Sie gewährleisten eine breitere Testabdeckung in kürzerer Zeit, reduzieren das Fehlerrisiko und ermöglichen die frühzeitige Erkennung von Anomalien. Dieser präventive Ansatz verkürzt den Korrekturzyklus und begrenzt Verzögerungen im Zusammenhang mit Code-Qualitätsproblemen. Indem sie technische Aufgaben vereinfachen und schnelle, maßgeschneiderte Lösungen bieten, ermöglichen Large Language Models Unternehmen, agiler auf Marktanforderungen zu reagieren. Diese Beschleunigung des Entwicklungszyklus führt zu häufigeren Updates, schnelleren Iterationen und einer besseren Fähigkeit, Produkte an die sich ändernden Bedürfnisse der Benutzer anzupassen. Entwicklungszyklen werden kürzer und bieten einen kritischen strategischen Vorteil in einer zunehmend anspruchsvollen Technologielandschaft.

Was sind die Herausforderungen beim Einsatz von LLMs?

Trotz ihrer vielen Vorteile haben Large Language Models bestimmte Einschränkungen, die sorgfältig verwaltet werden müssen. Ihre Effektivität hängt stark von der Qualität der während des Trainings verwendeten Daten und regelmäßigen Updates ihrer Wissensbasen ab. Darüber hinaus können Probleme im Zusammenhang mit algorithmischen Verzerrungen, Datensicherheit und Datenschutz auftreten, die Unternehmen operativen und rechtlichen Risiken aussetzen. Eine sorgfältige menschliche Überwachung bleibt unerlässlich, um die Zuverlässigkeit der Ergebnisse sicherzustellen, die regulatorische Compliance aufrechtzuerhalten und kritische Fehler zu vermeiden.

Datenschutz und Sicherheit

Das Training von LLMs basiert auf großen Datenmengen, oft aus verschiedenen Quellen, was Fragen zum Schutz vertraulicher Informationen aufwirft. Sensible Daten, die mit Cloud-Plattformen geteilt werden, können daher potenziellen Sicherheitsverletzungen ausgesetzt sein. Dies ist besonders besorgniserregend für Unternehmen, die in regulierten Sektoren tätig sind.

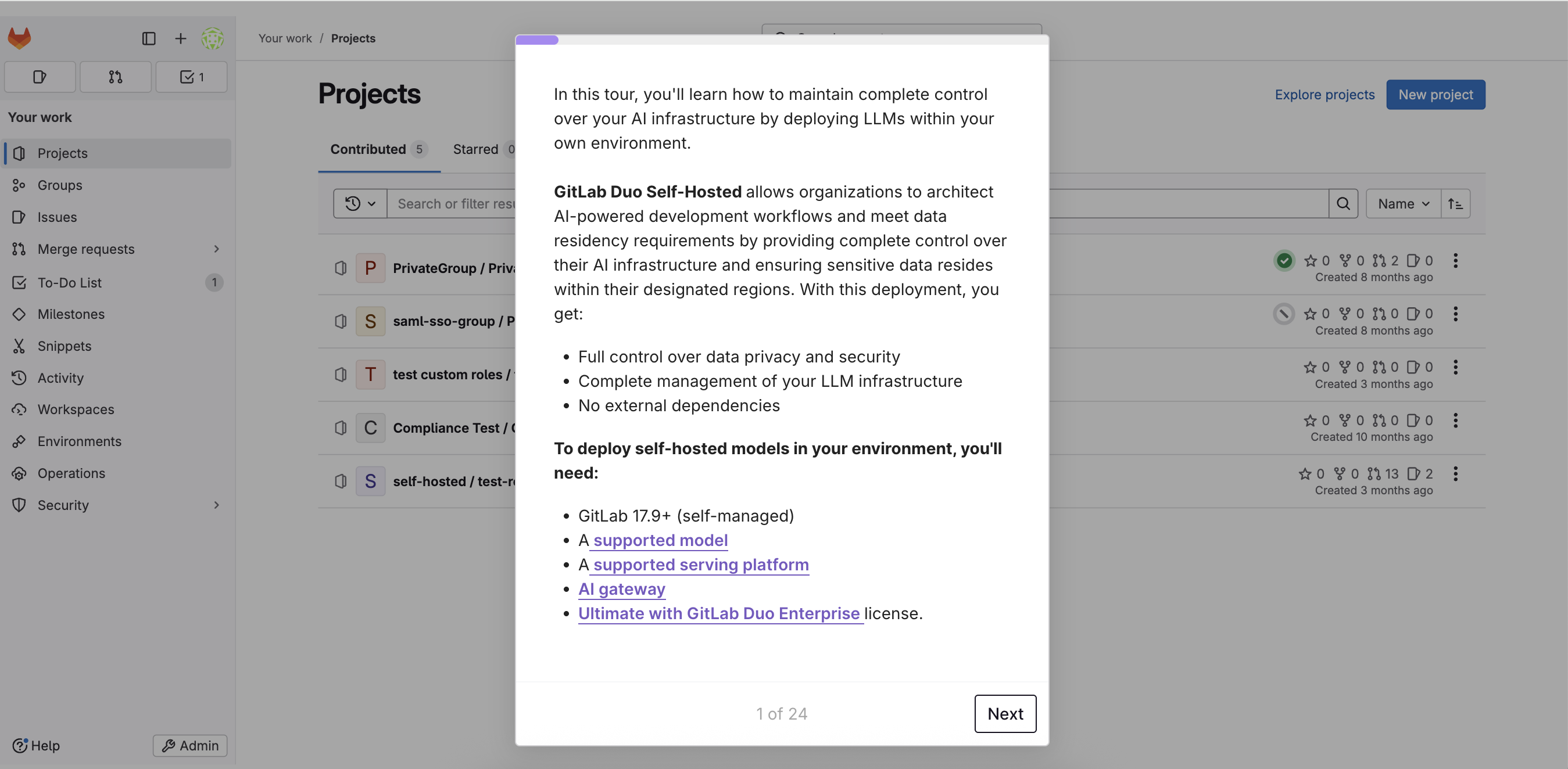

In Europa, wo strenge Vorschriften wie die DSGVO das Datenmanagement regeln, zögern viele Unternehmen, ihre Informationen an externe Dienste zu übertragen. Die regulatorischen Anforderungen, verbunden mit der Angst vor unbefugter Nutzung sensibler Daten, haben einige Unternehmen dazu veranlasst, sich für selbst gehostete Lösungen zu entscheiden, um die vollständige Kontrolle über ihre Systeme zu behalten.

Anbieter wie GitLab haben robuste Sicherheitsgarantien implementiert, wie die absichtliche Nicht-Speicherung persönlicher Daten und End-to-End-Verschlüsselung. Dies reicht jedoch möglicherweise nicht für die anspruchsvollsten Kunden aus, die eine vollständige Kontrolle über ihre Umgebungen bevorzugen. Die Implementierung hybrider oder On-Premises-Lösungen wird dann zu einer strategischen Notwendigkeit, um die Sicherheitsanforderungen bestimmter Unternehmen zu erfüllen.

Erfahre mehr über GitLab Duo Self-Hosted, indem du auf das Bild unten klickst, um auf unsere Produkttour zuzugreifen.

Genauigkeit und Zuverlässigkeit

Obwohl Large Language Models beeindruckende Ergebnisse produzieren können, ist ihre Leistung nicht unfehlbar. Sie können falsche, unvollständige oder inkonsistente Antworten produzieren. Diese Ungenauigkeit wird besonders problematisch im Kontext kritischer Aufgaben wie der Generierung von Sicherheitscode oder der Analyse sensibler Daten.

Darüber hinaus arbeiten LLMs auf der Grundlage probabilistischer Modelle, was bedeutet, dass sie den Inhalt, den sie verarbeiten, nicht wirklich "verstehen", sondern Vorhersagen basierend auf statistischen Wahrscheinlichkeiten produzieren. Dies kann zu technisch falschen oder sogar gefährlichen Empfehlungen führen, wenn sie ohne menschliche Validierung verwendet werden.

Um diese Fallstricke zu vermeiden, ist es unerlässlich, eine konstante Überwachung aufrechtzuerhalten und rigorose Validierungsprozesse zu etablieren. Die von LLMs bereitgestellten Ergebnisse müssen immer von Menschen überprüft werden, bevor sie in kritische Systeme integriert werden.

Eine Strategie regelmäßiger Modell-Updates, kombiniert mit proaktiver menschlicher Überwachung, kann Fehler reduzieren und die Zuverlässigkeit der Ergebnisse schrittweise verbessern.

Wie GitLab LLMs für GitLab Duo-Features nutzt

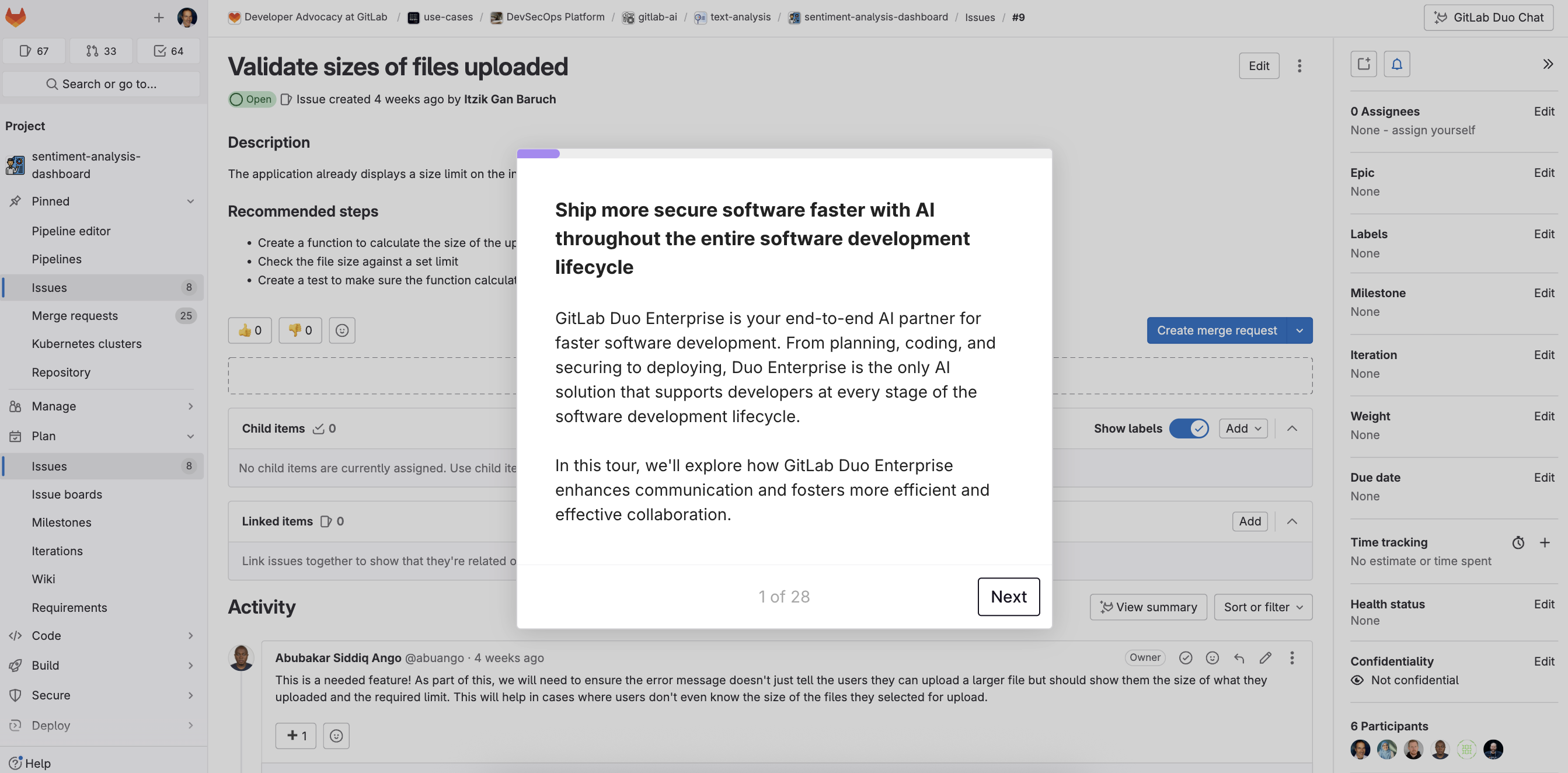

GitLab Duo nutzt die Kraft von Large Language Models, um DevSecOps-Prozesse zu transformieren, indem KI-gestützte Fähigkeiten über den gesamten Softwareentwicklungszyklus integriert werden. Dieser Ansatz zielt darauf ab, die Produktivität zu verbessern, die Sicherheit zu stärken und komplexe Aufgaben zu automatisieren, damit sich Entwicklungsteams auf Aufgaben mit hohem Mehrwert konzentrieren können.

KI-unterstützte Softwareentwicklung

GitLab Duo bietet kontinuierliche Unterstützung während des gesamten Softwareentwicklungszyklus mit Echtzeit-Empfehlungen. Entwicklungsteams können automatisch Unit-Tests generieren, detaillierte Erklärungen komplexer Code-Segmente erhalten und von Vorschlägen zur Verbesserung ihrer Code-Qualität profitieren.

Proaktive CI/CD-Fehleranalyse

Eine der Schlüsselfunktionen von GitLab Duo ist die Unterstützung bei der Analyse von CI/CD-Job-Fehlern. Mit LLM und KI können Teams schnell Fehlerquellen in ihren Continuous-Integration- und Deployment-Pipelines identifizieren.

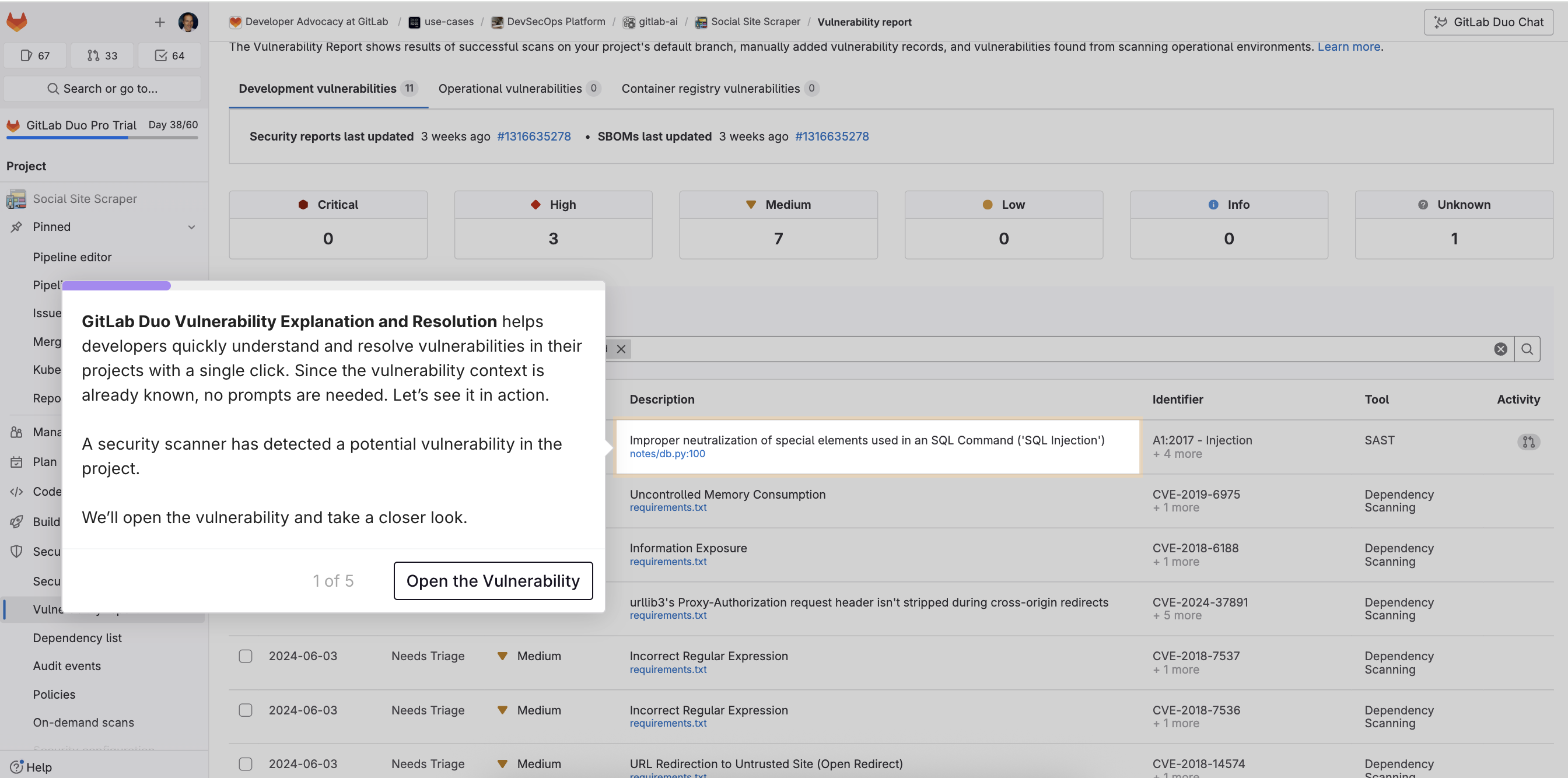

Verbesserte Code-Sicherheit

GitLab Duo integriert KI-basierte Sicherheitsfunktionen. Das System erkennt Schwachstellen im Quellcode und schlägt detaillierte Patches vor, um die Risiken zu reduzieren. Teams erhalten klare Erklärungen zur Art der identifizierten Schwachstellen und können automatisierte Patches über Merge Requests anwenden, die direkt von GitLab Duo generiert werden. Diese Funktion hilft, die Entwicklung zu sichern, ohne die Entwicklungszyklen zu verlangsamen.

Erfahre mehr über GitLab Duo Vulnerability Explanation and Resolution, indem du auf das Bild unten klickst, um auf unsere Produkttour zuzugreifen.

Schlüsselfunktionen von GitLab Duo

- GitLab Duo Chat: Diese Konversationsfunktion verarbeitet und generiert Text und Code intuitiv. Sie ermöglicht es Benutzern, schnell relevante Informationen in großen Textmengen zu suchen, einschließlich in Tickets, Epics, Quellcode und der GitLab-Dokumentation.

- GitLab Duo Self-Hosted: GitLab Duo Self-Hosted ermöglicht es Unternehmen mit strengen Datenschutzanforderungen, von den KI-Fähigkeiten von GitLab Duo mit Flexibilität bei der Wahl der Bereitstellung und LLMs aus einer Liste unterstützter Optionen zu profitieren.

- GitLab Duo Code Suggestions: Entwicklungsteams profitieren von automatisierten Code-Vorschlägen, die es ihnen ermöglichen, schneller sicheren Code zu schreiben. Repetitive und routinemäßige Codierungsaufgaben werden automatisiert, wodurch Softwareentwicklungszyklen erheblich beschleunigt werden.

- GitLab Duo ist nicht auf diese Funktionen beschränkt. Es bietet eine breite Palette von Features, die darauf ausgelegt sind, die Softwareentwicklung zu vereinfachen und zu optimieren. Ob es um die Automatisierung von Tests, die Verbesserung der Zusammenarbeit zwischen Teams oder die Stärkung der Projektsicherheit geht, GitLab Duo ist eine vollständige Lösung für intelligente und effiziente DevSecOps-Prozesse.

- Erfahre mehr über GitLab Duo Enterprise, indem du auf das Bild unten klickst, um auf unsere Produkttour zuzugreifen.

Feedback erwünscht

Dieser Blogbeitrag hat gefallen oder es gibt Fragen oder Feedback? Ein neues Diskussionsthema im GitLab-Community-Forum erstellen und Eindrücke austauschen.

Feedback teilen